DeepSeek 作为一款开源模型,为我们提供了本地部署使用的便利。通过本地部署,我们无需联网,就能随时借助大语言模型高效地完成各种任务。接下来,将以基于 Ollama 运行 DeepSeek 为例,详细介绍具体的操作步骤。

DeepSeek 作为一款开源模型,为我们提供了本地部署使用的便利。通过本地部署,我们无需联网,就能随时借助大语言模型高效地完成各种任务。接下来,将以基于 Ollama 运行 DeepSeek 为例,详细介绍具体的操作步骤。

首先,我们要安装 Ollama,它能帮助我们在本地轻松运行和管理大模型。

访问 Ollama 的官方网站。在网站页面中找到下载按钮,点击后会出现适合不同系统的版本选项。如果使用的是 Windows 系统,就选择对应的 Windows 版本进行下载。

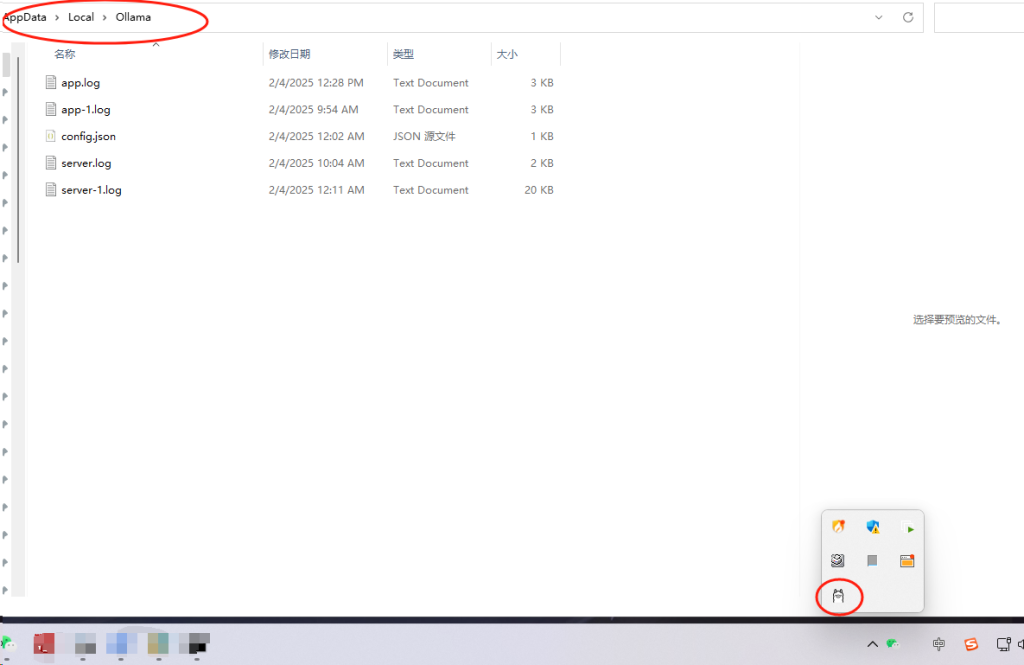

下载完成后,启动安装程序。安装过程完成后,安装窗口会自动关闭,此时在系统托盘图标区域,会出现一个常驻的 Ollama 标记,这意味着 Ollama 已成功安装在你的设备上。

接着,点击 Ollama 官网左上方的 “Models” 按钮,页面会展示出 Ollama 支持的各类模型。当前备受关注的 DeepSeek-R1 模型在页面中处于显眼位置,点击它进入该模型的主题页面。

进入 DeepSeek-R1 的页面后,能看到一个下拉菜单,里面包含多个版本。由于不同版本对硬件配置要求不同,特别是对显存的需求差异较大。如果你的主机配备的是 4090 显卡且显存为 24G,建议选择 32b 版本(通常数字越大,对显存的要求越高)。

选定模型版本后,点击右侧相应按钮,复制下载指令。这里获取到的指令是:ollama run deepseek-r1:32b。

在 Windows 系统中,在搜索栏输入 “cmd”,然后按下回车键,这样就能唤出命令行窗口,如果你觉得cmd界面颜色太深,比如我,更喜欢用powershell,也是可以的。将刚才复制的指令粘贴到命令行窗口中并运行,模型便开始下载。需注意的是,32b 版本的 DeepSeek-R1 模型容量约为 19GB,下载过程中请确保网络连接稳定且畅通。

模型下载完成后,就可以开启与 DeepSeek 的对话交互了。

不过,在命令行窗口进行对话操作,体验可能不够直观。为了获得更好的交互感受,我们还需要为其搭配一个美观的图文交互界面,比如open webui。后续我们将继续介绍如何获取和使用这样的界面,以便更便捷地使用 DeepSeek 模型。