三分钟说明白本地部署DeepSeek的过程,免费畅享LLM对话。

三分钟说明白本地部署DeepSeek的过程,免费畅享LLM对话。

我们尝试用三分钟跟大家说明白本地部署deepseek的过程。你可以通过Ollama运行DeepSeek大语言模型。首先安装Ollama,在Ollama的官网下载Windows版本,这个软件大概有800M,所以安装的过程还是非常快的。在电脑的右下角会有一个Ollama的一个图标,在Ollama的官网上找到DeepSeek的页面,因为是演示,所以我们下载它最小的一个模型。

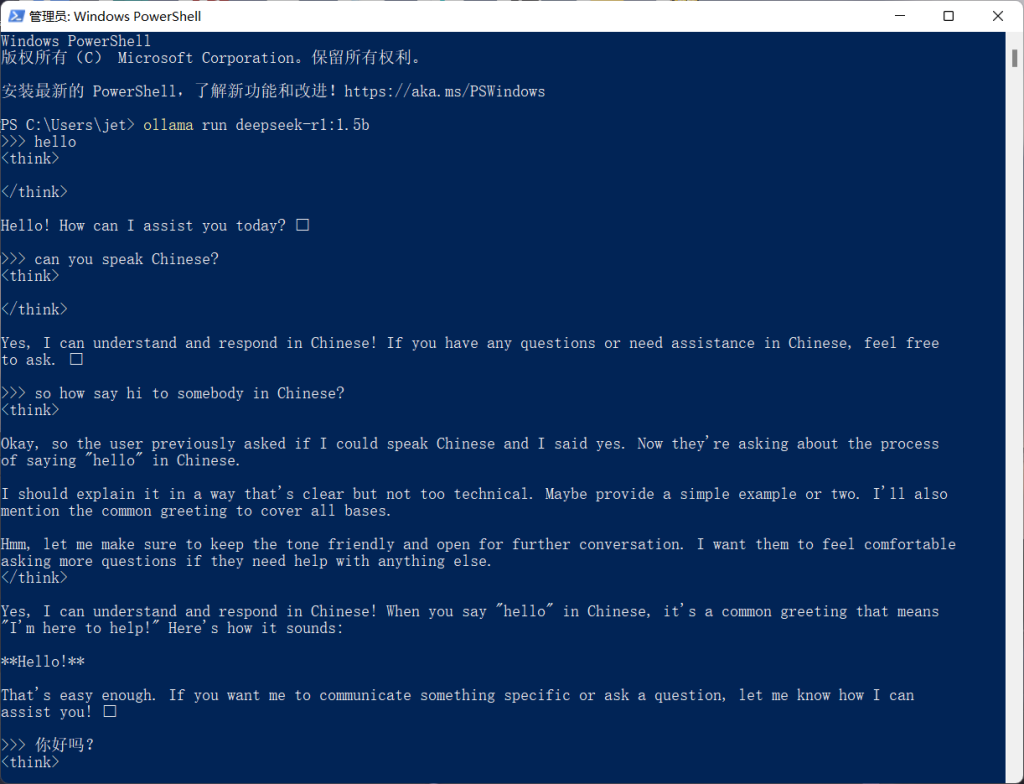

ollama run deepseek-r1:1.5b复制这个命令行,然后在Windows的cmd或者powershell中输入这个命令,下载大模型的过程比较漫长,这主要还是依赖于你的网络环境,特别是对接国际互联网的速度。

模型下载之后,我们可以通过命令行启动DeepSeek,命令和刚才是一样的,但是第二次运行不需要再次下载了。简单的英文对话是没有什么问题的,我们可以再试一下中文的,中文的对话也是很OK的。

只是这个界面比较简单,我们可以通过Open WebUI这个应用来实现网页对话,效果类似于豆包和文心一言等的网页版。安装Open WebUI的过程比较复杂,我们这里用Docker快速做安装和部署,使用Docker的过程,大家可以在本教程之外另行脑补。下载了Dcoker镜像之后,我们通过这个命令运行容器,其中最关键的就是指定Ollama的端口和地址。

docker run -d \

-p 3000:8080 \

-v /opt/ollama/open-webui:/app/backend/data \

-e HF_ENDPOINT=https://hf-mirror.com \

-e OLLAMA_BASE_URL=http://192.168.0.81:11434 \

-e DEFAULT_MODELS=deepseek-r1:1.5b \

--name open-webui \

--restart always \

ghcr.io/open-webui/open-webui:main现在Web服务已经运行起来了,对应的端口是3000,浏览器输入网址,首次使用初始化账号,这是本地注册,不是联网操作的。

现在我们换到Windows上就可以实现网页上跟DeepSeek对话,那么整个本地化部署的过程非常丝滑,对于技术小白来说也没有什么难度。网页对话的过程中,我们可以在后台看到前端对话的日志,方便跟踪和排查问题。